Roboter und Assistenzsysteme können unsere Arbeit und unseren Alltag entlasten – egal ob in der Pflege, zuhause oder im öffentlichen Raum. Nutzer müssen jedoch darauf vertrauen können, dass Roboter Befehle verstehen und verlässlich ausführen. Dies entscheidend darüber, ob Menschen Roboter akzeptieren. Technische Geräte werden bisher vor allem über ein Display bedient. Bei Robotern und Assistenzsysteme etablieren sich jedoch vielfältigere Interaktionsformen wie Sprache oder Gesten. Daher stellen sich die Fragen: Sprache, Geste oder Display – welche Interaktionsform ist die richtige? Oder sollte man mehrere Interaktionsformen gleichzeitig einsetzen? Das untersuchten wir in unserer Studie mittels Nutzerstudie und Befragung.

+++ Aufbau der Studie +++

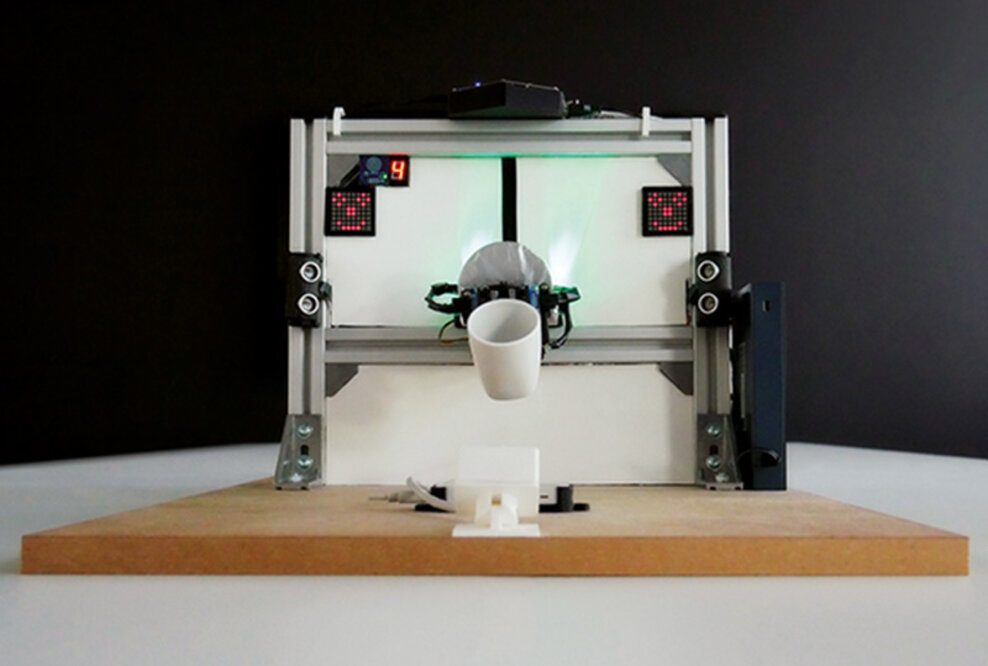

Für die Studie entwickelten wir einen Prototypen – den Scan-Roboter Paul. Er besteht aus einem Greifarm. Mit diesem sollten die Teilnehmer Produkte greifen und scannen. Den Befehl für das Öffnen und Schließen gaben die Teilnehmer via Sprache, Geste oder Display. Insgesamt bearbeiteten die 30 Teilnehmer fünf Aufgaben mit Hilfe des Scan-Roboters. Zu Beginn bekamen sie von uns eine bestimmte Interaktionsform vorgeben, mit der sie die Aufgabe lösen sollten. Um die Frustrationstoleranz zu testen, mussten wir die Teilnehmer „ärgern“. Das heißt wir manipulierten einige Aufgaben so, dass sich der Greifarm trotz des richtigen Befehls nicht öffnete. Die Teilnehmer mussten auf eine andere Interaktionsform wechseln, um den Prozess fortzuführen und die Aufgaben zu beenden. Wir untersuchten, nach wie vielen Versuchen die Teilnehmer die Interaktionsform wechselten und wie sie die User Experience mit und ohne Manipulation bewerteten.

+++ Sprache bevorzugt, aber … +++

Die Nutzer interagieren am liebsten mittels Sprache mit Robotern: 70 % der Teilnehmer wählten die Sprache als bevorzugte Interaktionsform im Umgang mit Robotern. Diese Interaktionsform zu verwenden, führt aber nicht zwingen zu einer besseren User Experience. Die Teilnehmer verzeihen dieser Interaktionsform nicht mehr Fehler als einer anderen Art der Interaktion. Die Teilnehmer wechselten beim Display nach 3,94, bei der Sprache nach 4,55 und bei der Geste nach 5 Fehlversuchen die Interaktion. Auch die UX litt während der manipulierten Aufgaben bei allen drei Interaktionsformen geleichermaßen. Eine bestimmte Interaktionsform, die Nutzer unabhängig vom Kontext bevorzugen und deren Einbindung per se die UX steigert, gibt es also nicht.

+++ Fokus auf den Nutzer +++

Für zukünftige Roboter-Projekte bedeutet dies: Weder das Versteifen auf die Interaktionsform Sprache noch das Anbieten einer Vielzahl von Interaktionsformen ist der richtige Weg. Vielmehr müssen Entwickler den Nutzer im Sinne des nutzerzentrierten Designs in den Mittelpunkt der Entwicklung rücken. Sie sollten daher die Interaktionsform auf die jeweiligen Bedürfnisse und den Nutzungskontext anpassen.

Die Studie entstand im BMBF-Projekt GINA.